Auf dem RoadtrIP-Event am 13. November bei PLAZAMEDIA in München widmete sich Felix Scheuer, Projektingenieur bei LOGIC media solutions, dem Thema der Remote-Produktion. Dabei erläuterte er, welche Rollen die Standards ST2110 und das Kompressionsverfahren JPEG XS dabei spielen. Scheuer betonte, dass die Verlagerung von Produktionsprozessen ins IP-Netzwerk eine immer größere Bedeutung für die Medienproduktion gewinnt, und zeigte an einem Beispiel auf, wie dieser Wandel in der Praxis umgesetzt werden kann.

Drei Säulen der Live-Produktion

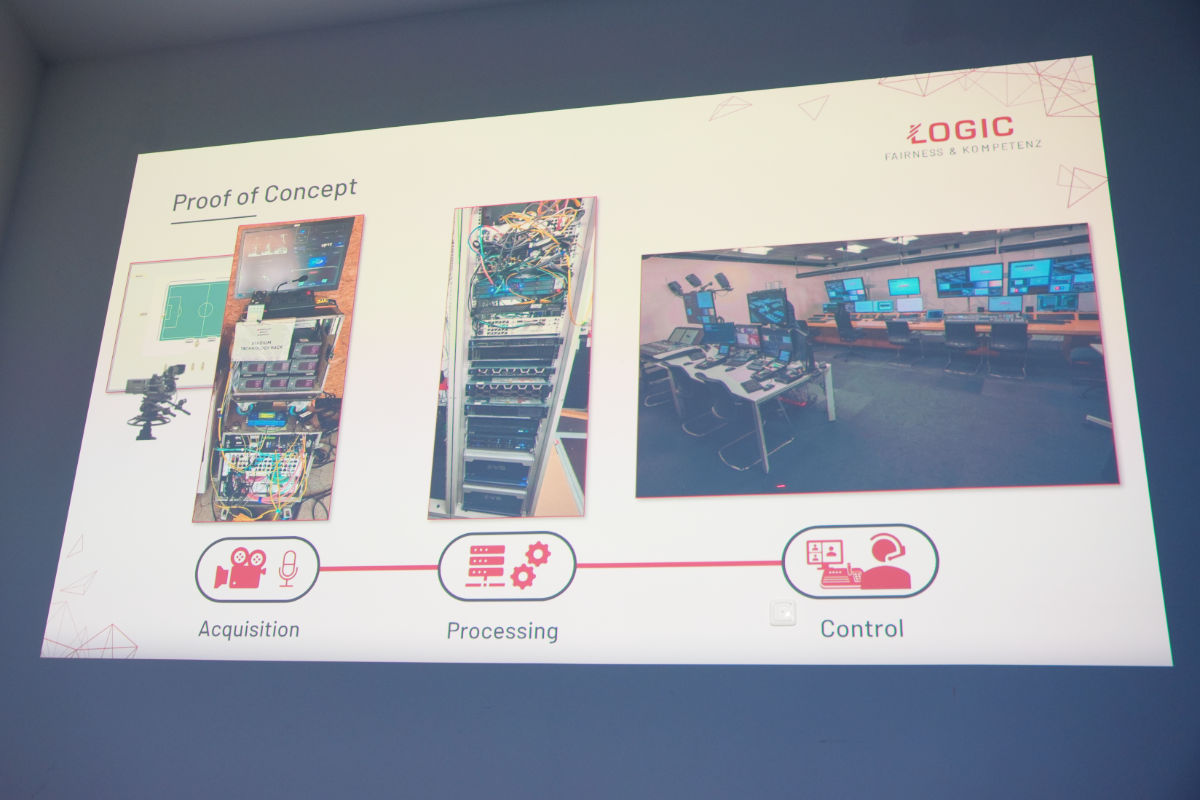

Scheuer beschrieb eingangs die grundlegenden Schritte einer Live-Produktion, die aus der Akquisition (Bild- und Tonaufzeichnung), der Verarbeitung und der Kontrolle der Signale bestehen. Traditionell werden Kameras und Mikrofone am Veranstaltungsort platziert, während alle zentralen Produktionsschritte direkt vor Ort stattfinden. Mit fortschreitender Technologie und dem Einsatz von IP-Standards können diese Abläufe inzwischen jedoch effizienter und dezentralisiert gestaltet werden.

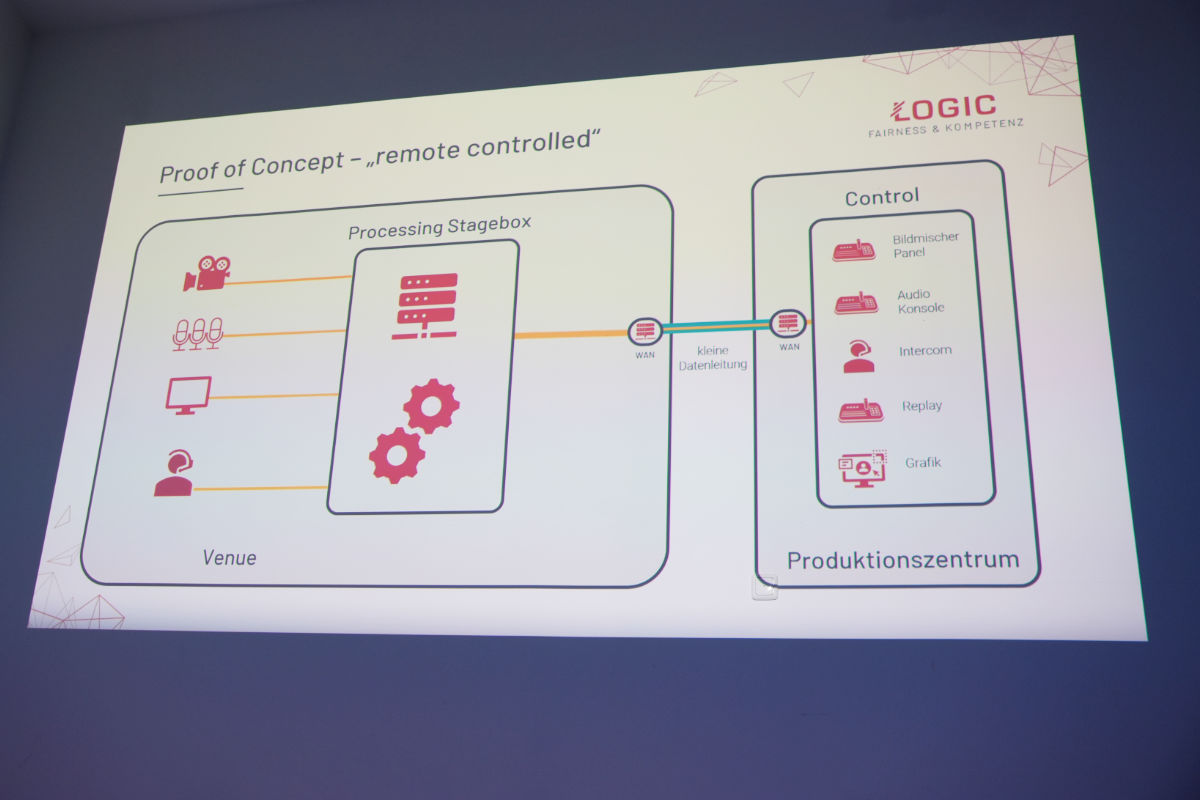

Durch die Verwendung von IP-basierten Lösungen wie ST2110 wird es möglich, den Produktionsprozess zu dezentralisieren und teilweise oder sogar vollständig zu verlagern. Scheuer unterschied hierbei verschiedene Produktionsmodelle. Zum einen die Remote-Control-Produktion, bei der die Produktions- und Verarbeitungstechnik zwar noch vor Ort untergebracht ist, jedoch aus der Ferne gesteuert wird. Zum anderen die zentrale Remote-Produktion, oft auch unter dem Begriff REMI (Remote-Integration) bekannt, die noch einen Schritt weiter geht: Kameras und Mikrofone befinden sich am Veranstaltungsort, während die Signalverarbeitung sowie die Regie vollständig in einem Produktionszentrum, häufig dem Hauptsitz eines Senders, erfolgen. Scheuer zeigte zudem auf, wie diese Konzepte in verteilte Produktionsmodelle münden können, bei denen sich beispielsweise Datenzentren, Produktionsstätten und Kontrollräume an unterschiedlichen Standorten befinden: „Wenn wir das Ganze ein bisschen weiterspinnen, können wir ja auch einen dritten Ort machen, indem wir das Ganze verteilen.“

Remote-Produktion auf Basis von ST2110 & JPEG XS

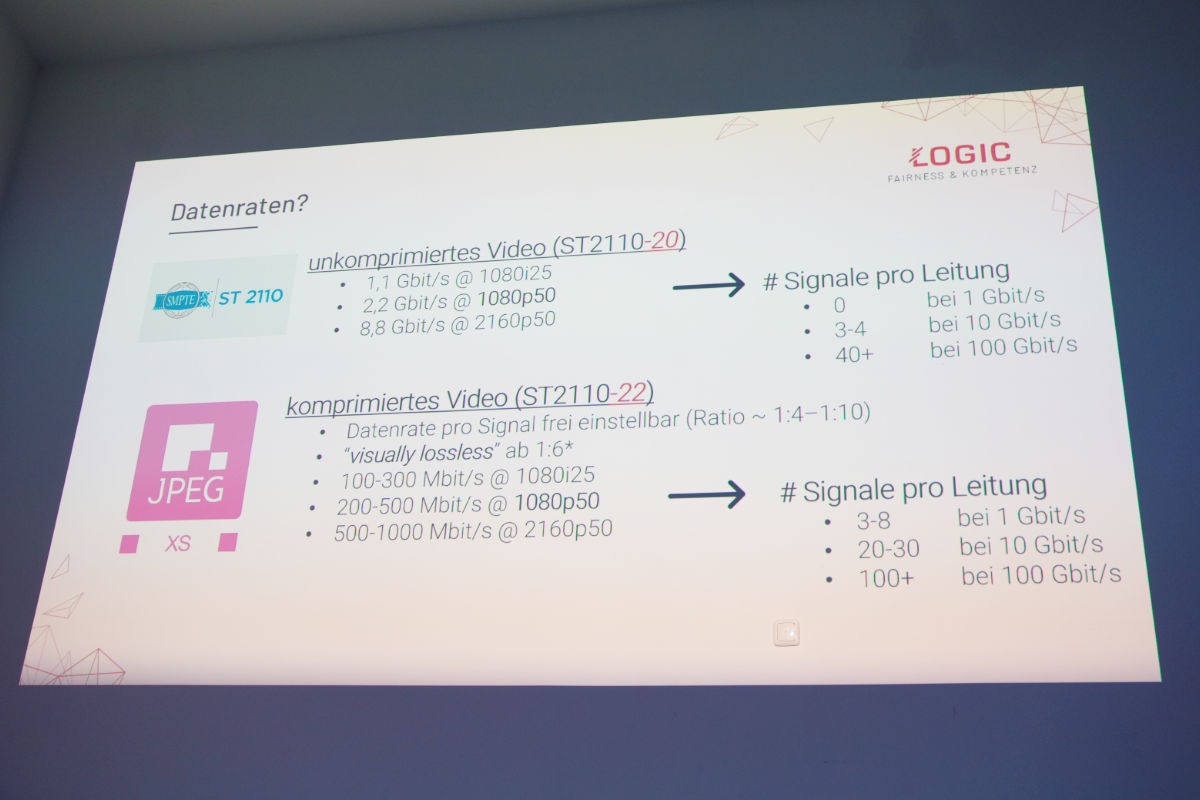

Eine wichtige Rolle für die Realisierung solcher Remote-Produktionsszenarien spielen laut Scheuer Standards wie ST2110 und die Anwendung von JPEG XS als Kompressions-Codec. Das Kompressionsverfahren ermöglicht es, hochauflösendes Video in 1080i25 bei sehr geringer Latenz und nahezu verlustfrei („visually lossless“) mit Datenraten von typischerweise 100 Mbit/s bis 300 Mbit/s zu übertragen. Dadurch können laut Scheuer auch mehrere Videokanäle gleichzeitig über eine Leitung von beispielsweise 1 Gigabit/s laufen. Während für einen einzelnen unkomprimierten HD-Video-Feed in ST2110-20 rund 1,5 Gigabit/s Bandbreite benötigt werden, ermöglicht JPEG XS bei vergleichbarer Qualität eine deutliche Reduktion. „Das Coole an JPEG XS ist zudem, dass wir pro Kamera, pro Programmbild, das wir transportieren, individuell festlegen können, wie viel Datenrate wir dem spendieren“, so Scheuer. Dies mache eine effizientere Nutzung von Bandbreite möglich und erlaube die Remote-Anbindung von Kameras und anderen Geräten in Produktionsumgebungen mit begrenzten Datenkapazitäten.

Proof of Concept bei der Fußball-Produktion

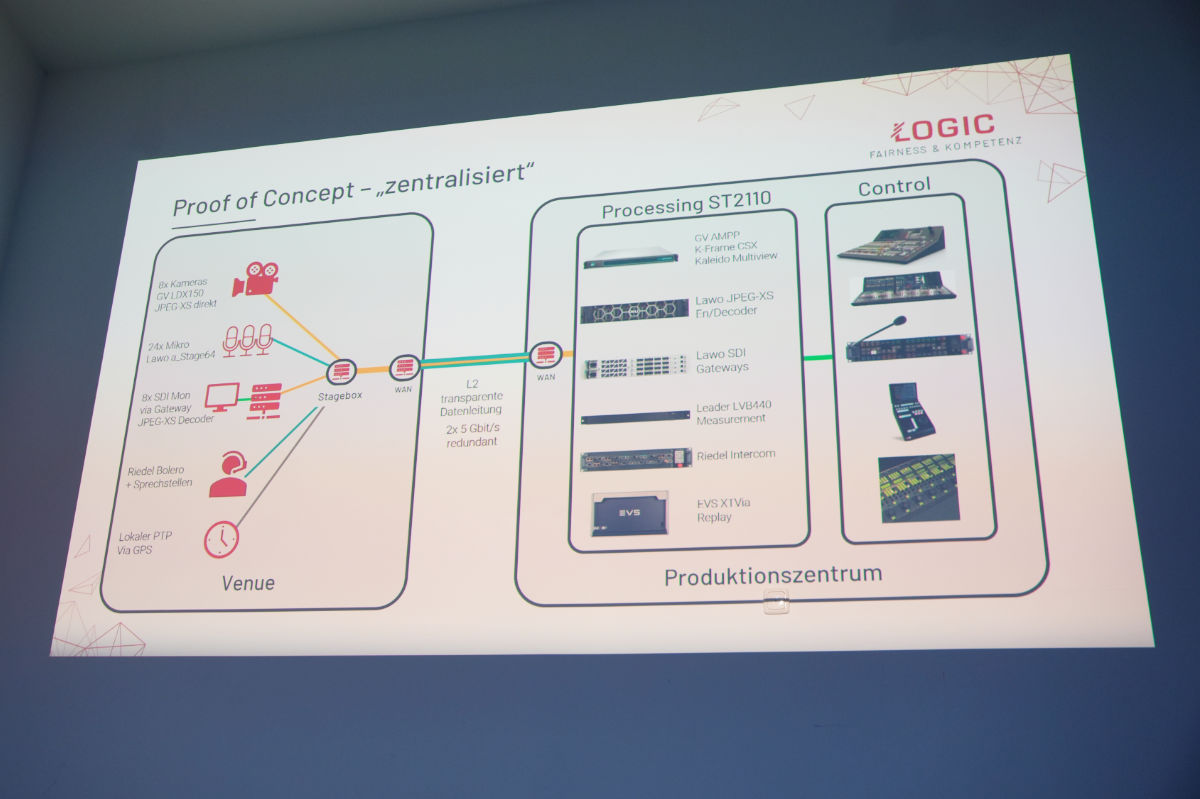

Scheuer verdeutlichte die praktische Umsetzung einer Remote-Produktion auf Basis von ST2110 und JPEG XS anhand einer Fußball-Produktion in Düsseldorf, die aus dem RTL-Produktionszentrum in Köln gesteuert wurde. Im Stadion kamen dabei acht Kameras von Grass Valley zum Einsatz. Außerdem wurden insgesamt 24 Mikrofone für die Audioaufnahme und mehrere Monitore für Talents und Techniker installiert. Für die Intercom-Kommunikation zwischen dem Stadion und der Regie in Köln setzten die Verantwortlichen auf Bolero-Funksprechstellen von Riedel, die ebenfalls an das IP-Netzwerk angebunden waren.

Alle lokalen Kamerasignale sowie die Audio-, Intercom- und Control-Daten wurden via ST2110-Standard über zwei dedizierte 5-Gigabit-Netzwerkverbindungen von Düsseldorf nach Köln übertragen. Die Signal-Kodierung und -Dekodierung erfolgte über LAWO HOME Apps. Im Stadion installierte das Team lediglich eine kompakte Stagebox-Lösung, bestehend aus einem Netzwerk-Switch, den Kameranetzteilen und Gateway-Komponenten. Gesteuert wurde das Netzwerk über VideoIPath, das auch sicherstellte, dass nur JPEG XS codierte Videofeeds über das Netzwerk geschickt wurden. „Unkomprimierte Video-Daten hätten relativ schnell dafür gesorgt, dass wir die Datenleitungen überbuchen und dass uns alle anderen Signale um die Ohren fliegen“, erklärte Scheuer.

Im zentralen Produktionszentrum in Köln setzte man für Bildmischer und Multiviewer auf das cloud-native Produktionssystem Grass Valley AMPP (Agile Media Processing Platform). Dieses lief auf einem 2-HE-Dell-Server mit 100-Gigabit-Netzwerkanschluss, der mit der IP-Infrastruktur verbunden war. Ein Leader LVB440 IP-Waveform-Monitor sorgte für die technische Überwachung der Bildsignale. Zusätzlich wurden EVS-Server für Zeitlupen-Wiederholungen eingebunden und konnten über die IP-Infrastruktur mit dem restlichen System interagieren. „Mit unserem Setup lag die reine Netzwerklatenz zwischen Düsseldorf und Köln bei 3,5 Millisekunden Roundtrip. Die menschliche Wahrnehmungsschwelle für Delay liegt bei über fünf Millisekunden“, kommentierte Scheuer.

Keine hochwertige Netzwerkanbindung, kein Problem

Scheuer ging in seinem Vortrag auch auf die Situation ein, wenn keine ausreichend großen Datenleitungen zur Verfügung stehen. „Es kann sein, dass der Dienstleister ausgebucht ist und uns nicht mehrere Gigabit, sondern vielleicht nur 100 Mbit zur Verfügung stellen kann“, erklärte Scheuer. In diesem Fall könnte man auf das Remote-Control-Konzept samt Processing Stagebox vor Ort im Stadion, zurückgreifen – datenintensive Verarbeitungsschritte würden dann lokal ausgeführt, während ausschließlich die Steuerung aus der Ferne erfolgt. Der 2-HE-Dell-Server würde dann nicht im Rack des Produktionszentrums stehen, sondern in der Stagebox. „Das Setup ist dann im Stadion zwar etwas größer, etwas schwerer, aber der Footprint ist immer noch kleiner, als einen Ü-Wagen samt Mannschaft hinzuschicken“, so Scheuer.

Mehr als nur Remote-Produktion

Obwohl sich ST2110 und JPEG XS laut Scheuer sehr gut für Remote-Produktionskonzepte eignen würden, seien sie nicht auf die Live-Produktion beschränkt, erklärte Scheuer abschließend. Sie seien beispielsweise auch für Broadcaster mit mehreren Standorten geeignet. „Wir können damit genauso gut verschiedene Standorte vernetzen, indem wir eine reine Datenleitung schaffen, wie wir sie auch im Bereich der Remote-Produktion einsetzen.“ Dies ermögliche es, Video-, Audio- und Datensignale in hoher Qualität und mit sehr geringer Latenz zwischen verschiedenen Standorten zu übertragen, wodurch man auf teure und aufwändige Point-to-Point-Verbindungen verzichten könne. Zentrale Ressourcen wie Rechenzentren oder Kontrollräume könnten durch den Einsatz dieser Technologien standortübergreifend zugänglich gemacht werden, was zu einer effizienteren und flexibleren Produktionsumgebung führen würde.