Die Zukunft kreativer Arbeit ist längst angebrochen. Sie passt in die Hosentasche, arbeitet KI-gestützt, vernetzt sich über Plattformgrenzen hinweg und stellt das Machen über das Warten. Wer heute Inhalte produziert, denkt nicht mehr in Produktionsplätzen, sondern in Situationen: im Zug, am Flughafen, zwischen zwei Sessions auf einem Festival. Adobe reagiert auf diese neue Arbeitsrealität mit einem Werkzeug: Die kostenlose Premiere-App für iOS soll professionelle Schnittarbeit auf dem Smartphone ermöglichen – ohne Kompromisse, ohne Spielerei. Was das bedeutet, wie es funktioniert und welche Haltung dahinter steht, erklärt Robert Hranitzky im Gespräch mit mebucom.

Ein Werkzeug, das aus der Praxis kommt

Hranitzky ist nicht nur offizieller Evangelist von Adobe, sondern auch Designer, Motion Graphics Artist und jemand, der selbst jahrzehntelang freiberuflich gearbeitet hat. Wenn er sagt, dass ein Tool funktioniert, dann meint er das aus der Praxis heraus. Er gehört nicht zu denen, die Marketingfloskeln verbreiten, sondern zeigt im Interview vor allem eines: Begeisterung für technische Lösungen, die reale Probleme lösen. „Ich habe schon Videos am Flughafen geschnitten, mit der App auf dem iPhone – beruflich, aber auch privat. Zum Beispiel ein kleines Urlaubsvideo für meine Kids, das sie am nächsten Morgen anschauen konnten. Diese Flexibilität ist keine Spielerei. Sie ist produktiv.“

Performance statt Placebo

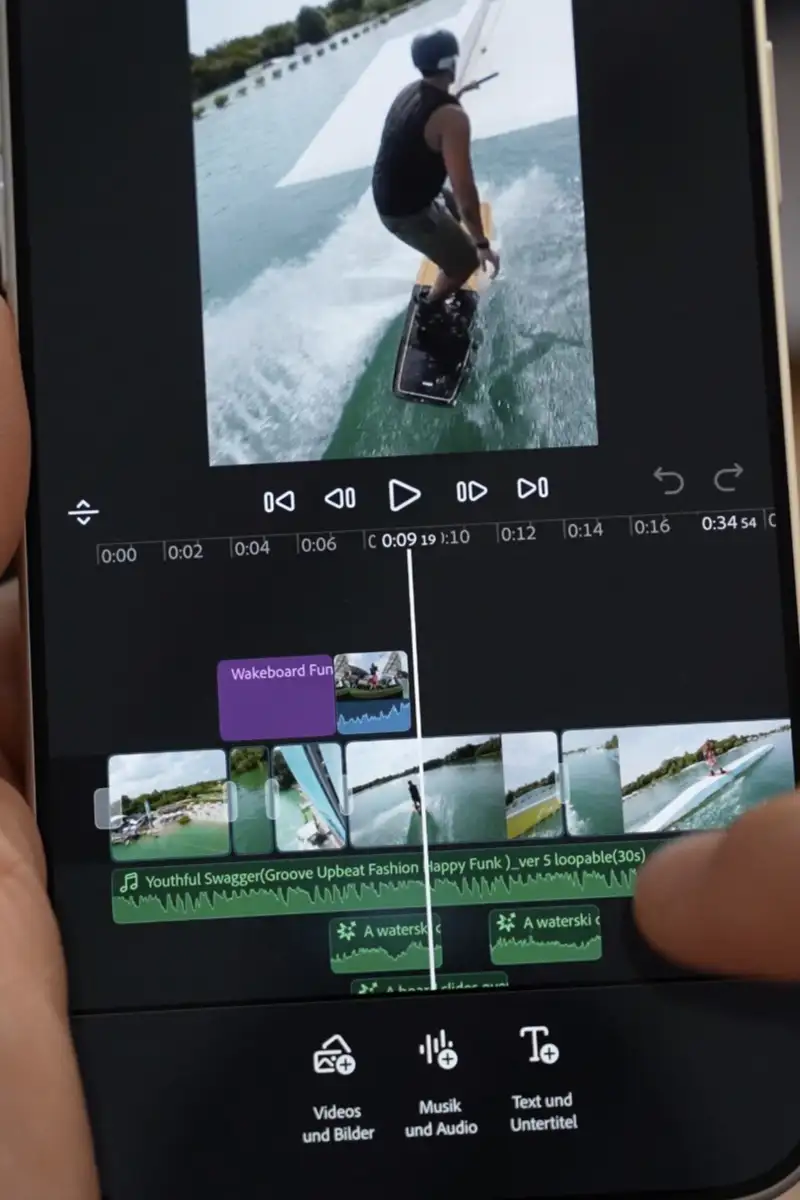

Die neue Premiere-App für iOS ist genau für solche Szenarien entwickelt worden und das spürt man. Sie ist nicht das nächste Light-Produkt für schnelle Social-Edits, sondern ein ernstzunehmendes Tool. Native 4K- und HDR-Bearbeitung gehört ebenso dazu wie eine voll ausgestattete Multitrack-Timeline mit Layern für Video, Audio, Text und Effekte. Nutzer:innen können direkt in die Timeline zoomen, Clips verschieben, Farben korrigieren oder Sound verbessern – alles flüssig, alles direkt auf dem Gerät. Hranitzky nennt die Performance „rattenschnell“ und „butterweich“. Das klingt nach Superlativ, ist aber handfest gemeint: „Man merkt einfach, wie performant diese App gebaut ist. Das ist nicht irgendein gekapseltes Web-Frontend. Das ist native iOS-Entwicklung mit all ihren Vorteilen.“

Neue Schnittrealitäten

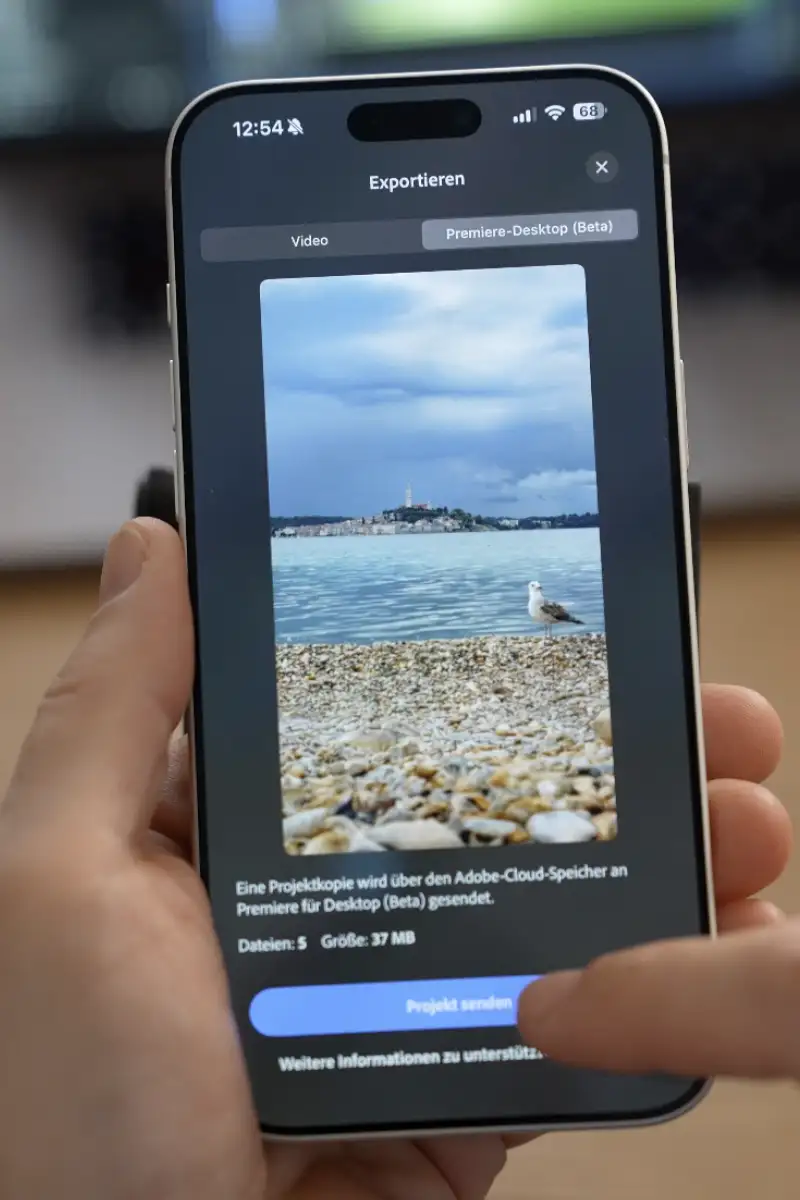

Wer Schnitt auf dem Smartphone für unprofessionell hält, verkennt laut Hranitzky die Realität der Geräte – und der Nutzer:innen. „Viele Creator:innen, auch große, arbeiten heute hybrid. Sie nutzen Desktop-Tools für große Projekte, aber schneiden Teile mobil vor – sei es für Reels, Social Assets oder den schnellen Recap nach einem Event.“ Mit der neuen App könne man beides tun: entweder einen kompletten Schnitt mobil produzieren oder den Rohschnitt in Premiere für Desktop überführen. Die Übertragung erfolgt über die Creative Cloud, inklusive aller Medien und Metadaten. In der aktuellen Beta-Version von Premiere Pro lässt sich das Projekt anschließend direkt öffnen und weiterbearbeiten.

Idee vor Infrastruktur

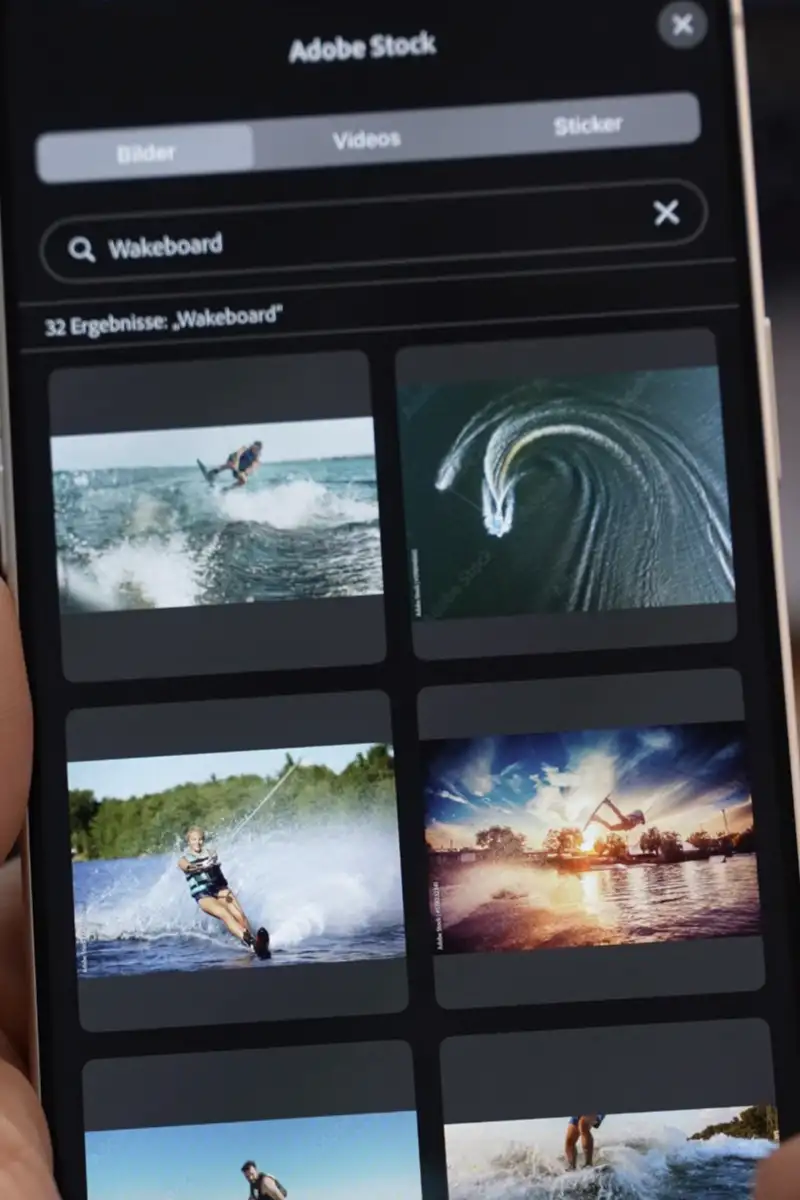

Inhaltlich setzt Adobe auf einen Ansatz, der sich als Demokratisierung der Produktion beschreiben lässt. „Früher hatte man Ausreden: zu wenig Technik, keine Kamera, kein Schnittplatz. Heute steckt all das in der Hosentasche“, sagt Hranitzky. „Damit zählt wieder mehr, was du erzählen willst – und wie du es erzählst.“ Der Fokus verschiebt sich vom Werkzeug zur Idee. Auch deswegen wurde die App so gestaltet, dass sie mit wenigen Klicks Inhalte ermöglicht – nicht verhindert. Dazu zählt auch der direkte Zugriff auf Adobe Stock: Bilder, Musik, Soundeffekte, Templates und Typo-Elemente lassen sich direkt aus der App heraus verwenden. Auch das Exportieren ist nicht künstlich limitiert. Kein Wasserzeichen, keine Auflösungsbegrenzung. Wer mit 4K-Material arbeitet, bekommt auch 4K heraus.

Künstliche Intelligenz – praktisch gedacht

Ein besonderes Augenmerk liegt auf den KI-Funktionen. Adobe hat seine Firefly-Plattform tief in die App integriert und damit neue kreative Möglichkeiten eröffnet. Besonders eindrucksvoll ist die Sprachverbesserung durch „Enhance Speech 2.0“. Selbst bei Aufnahmen in lauter Umgebung kann die App die Stimme deutlich herausarbeiten und Nebengeräusche minimieren – ohne Zusatzkosten, ohne Abo-Falle. „Ich habe ein gutes Mikro hier. Trotzdem klingt meine Stimme nach dem Enhance-Prozess noch besser – einfach klarer, voller“, sagt Hranitzky.

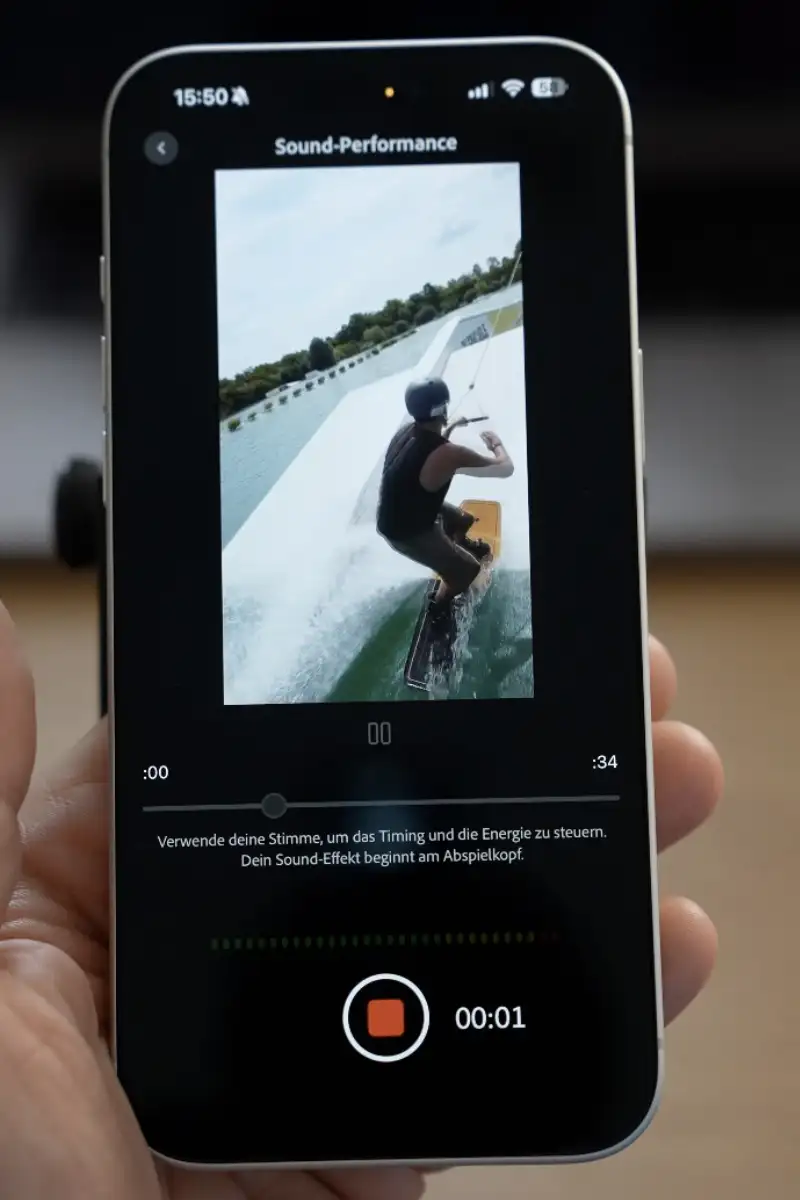

Neben dieser Funktion gibt es auch eine automatische Untertitel-Erstellung, die aus gesprochenem Ton sofort Text generiert. Auch die Generierung von Soundeffekten wurde durch KI erweitert. Nutzer:innen können mit ihrer Stimme einen Klang vorsummen oder beschreiben – etwa einen Wassersplash, ein dumpfes Auftreffen oder einen metallischen Hall. Die App generiert daraus auf Basis von Firefly einen passenden Effekt – in mehreren Varianten. „Ich hatte ein Drohnenvideo von einem Event ohne Ton. Die Soundeffekte habe ich einfach eingesprochen – und Firefly hat sie in perfekt getimte Effekte übersetzt“, berichtet Hranitzky.

Bild zu Video, Foto zu Story

Auch die visuelle Bearbeitung geht deutlich über klassische mobile Tools hinaus. Horizontale Fotos lassen sich in vertikale Bilder umwandeln, etwa um sie für Reels oder Storys zu nutzen. Wer möchte, kann einzelne Bildelemente animieren und so Bewegung ins Standbild bringen. Ein Strandfoto mit einer Möwe? In der App wird die Möwe plötzlich lebendig. Selbst Sticker für Social Media lassen sich per KI generieren und direkt in Clips einsetzen. Das Ziel ist klar: weniger Suche, mehr Schaffenszeit.

Ein Werkzeugkasten, kein Korsett

Trotz all dieser Möglichkeiten ist Hranitzky weit davon entfernt, KI als Allheilmittel zu betrachten. Er beschreibt sie als Werkzeug, nicht als Ersatz für Kreativität. „Ich komme aus der Typografie, habe analog gelernt, mit Bleisatz gearbeitet. Ich habe viele technologische Umbrüche erlebt – von der Digitalkamera bis zu After Effects. Immer hieß es: Das macht den Beruf kaputt. Und jedes Mal zeigte sich: Die, die gestalten können, setzen sich durch – egal mit welchem Tool.“

Die eigentliche Gefahr sieht er nicht in der kreativen Nutzung, sondern im Missbrauch. Deepfakes, Desinformation, manipulierte Inhalte: Das sind reale Probleme. Adobe reagiert mit der Content Authenticity Initiative. Metadaten kennzeichnen KI-generierte Inhalte, um Transparenz zu schaffen. Auch Plattformen wie Instagram oder TikTok setzen inzwischen auf solche Labels. „Es geht nicht darum, Technologie zu verbieten. Aber wir müssen sie verantwortungsvoll einsetzen“, so Hranitzky.

Community statt Konzernlogik

Was die Weiterentwicklung der App betrifft, zeigt sich Adobe offen. Das Produkt wurde bereits in der Testphase mit realem Nutzerfeedback optimiert und wird stetig aktualisiert. Neue Funktionen wie automatisierter Schnitt oder KI-gestützte Layoutvorschläge sind bereits in Planung. „Schon einen Tag nach Release hatten wir neue Features in der Beta“, berichtet Hranitzky. Wer mitwirken will, kann direkt aus der App heraus Feedback geben – und wird gehört. „Das landet nicht in irgendeinem Void. Das wird gelesen – und umgesetzt.“

Die Technik ist da. Die Idee zählt.

Was bleibt nach einer Stunde Gespräch mit einem Mann, der für kreative Tools brennt? Vor allem ein Eindruck: Diese App ist keine Spielerei, sondern Ausdruck eines Wandels. Sie passt zu einer Welt, in der Ort und Zeit des Kreativprozesses flexibel geworden sind. In der Technik nicht mehr das Problem ist, sondern Teil der Lösung. Und in der gute Gestaltung nicht durch Komplexität entsteht, sondern durch den klaren Umgang mit Ideen und Werkzeugen. Premiere für iOS ist eines davon – und vielleicht eines der wichtigsten der kommenden Jahre.