Maxine verarbeitet Videoanrufe in der Cloud und soll dank künstlicher Intelligenz die Anrufqualität auf unterschiedliche Weise verbessern. So können Gesichter von Anrufern neu ausgerichtet werden, so dass sie immer direkt in die Kamera schauen, gesprochenes kann in Echtzeit übersetzt und transkribiert werden.

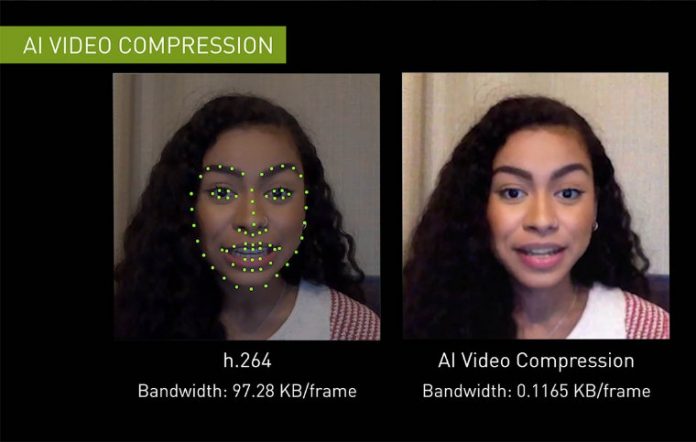

Die interessanteste Ankündigung ist jedoch, dass der Bandbreitenbedarf für Video im Gegensatz zum H.264-Streaming-Video-Komprimierungsstandard auf ein Zehntel reduziert werden soll. Möglich wird diese Einsparung laut NVIDIA indem nur „Schlüsselgesichtspunkte“ übertragen werden, die für ein authentisches Kommunikationserlebnis nötig sind.

Das eingesetzte Video-Kompressionsverfahren nutzt eine KI-Methode, die als „Generative Adversarial Networks“ oder GANs bekannt ist. Diese Methode versucht Teile von Gesichtern zu rekonstruieren und ist die selbe, die auch aus diversen Deep-Fake-Videos bekannt ist.

Maxine ist keine Verbraucherplattform, sondern ein Toolkit für Drittfirmen zur Verbesserung ihrer eigenen Software. Bislang hat NVIDIA jedoch nur eine Partnerschaft angekündigt – mit der Kommunikationsfirma Avaya, die ausgewählte Funktionen von Maxine nutzen wird.

Die fehlende Bandbreite stelle auch heute noch die größte Einschränkung dar, erklärte Richard Kerris, NVIDIAs General Manager für Medien und Unterhaltung kürzlich. Daher sei es wichtig, wirklich nur das zu übertragen, was übertragen werden muss. KI kann, so Kerris, beide Enden einer Unterhaltung rekonstruieren und schafft ein authentisches Videokonferenz-Erlebnis.

Interessant wird zu sehen sein, ob auch Broadcaster diese Technologie für bestimmte Anwendungen nutzen können, um die Übertragung schlank zu halten. Dass sich Maxine auch außerhalb von Videokonferenzen nutzen lässt ist nicht bekannt.